如题,本文是一篇关于Apple Vision Pro的初次上手体验测评。我在Apple Eaton Center花费约1个小时的时间(实际Vision Pro在我头上的时间,约有30分钟到40分钟),同Apple的一位工作人员一同探索了关于Vision Pro的很多地方。整个过程下来,我有很多希望去分享的内容。

实际体验完后,和看完其它科技测评博主的视频相比,我的结论并未发生改变。和以往一样,我习惯性的会把文章想表达的核心内容以及我的结论放在最开头的位置。我个人当前的看法是:Vision Pro是一台具有前瞻性的空间计算设备,其设计的初衷令它在当前的市场上没有竞争对手。可是,抛开特定的用途,将它视作为消费级电子产品,以当前的价格来看,它是不合格的。即便已经过了如此之久的时间,它依然存在太多亟需解决的问题。

先置条件说明

- 我体验到的Vision Pro仅为样机,芯片为M5,其它配置不明。

- 我本身双眼有175到225度的近视和轻微的散光,苹果为我进行了基于我佩戴眼镜的现场镜片测量与定制,但只是为演示作用。实际购买的机型并不知道体验是否会有出入。

- 体验时只有我一个人和工作人员,他全程指导我的使用并有一台iPad在实时镜像我眼前的画面,实际系统学习成本和操作难易度也许会因为是否有人在边上指导而变。

- 对于演示机而言,我无法进行与其它Apple设备的联动,也无法连接其它的配件。关于“Vision如何配合其它设备进行使用”,我会结合个人在网上看到其它的测评同今天实际的体验去推演。

- 其它有关演示机的地方我会在文中单独标注进行说明。

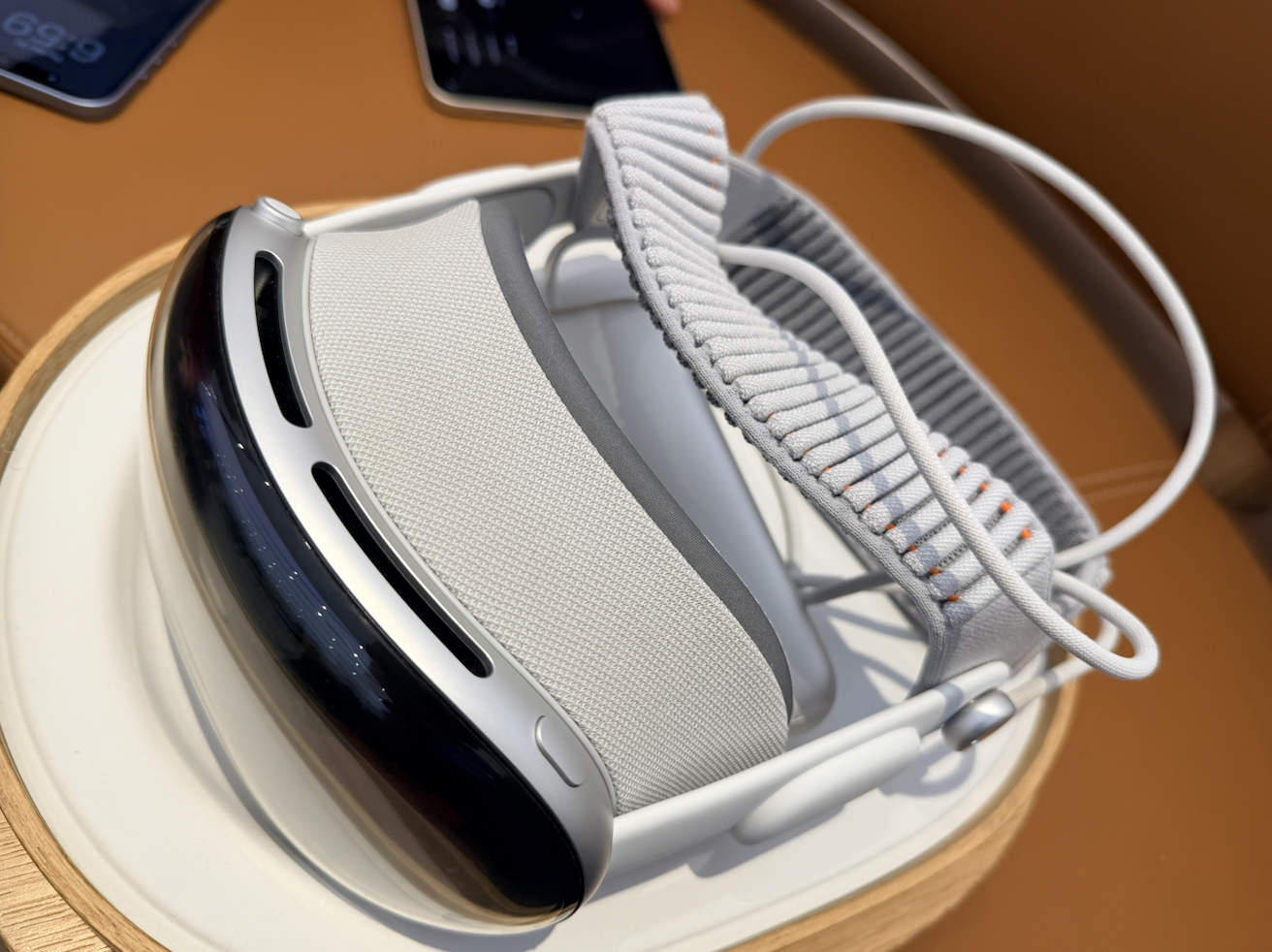

外观

Vision Pro 长相还是接近一台普通VR,但做工和质感却非常不同。在得到Apple工作人员的的允许后,我拍摄了几张我今天体验的那一台设备的照片。

佩戴

佩戴Vision Pro的30分钟左右时间里,其戴在头上的存在感相当明显,然而和很多测评不同,我并未感觉其格外压迫我的面部。Vision Pro依然是一个不轻的设备,毕竟官网的信息中,它的重量为750–800克。这可能是因为新的头带有帮助将压力更为均匀的分布在了整个头上。

我的Demo机型出现了严重的漏光问题。具体表现为鼻梁位置无法贴合,导致光会从下方漏出来。无论我如何去调整头戴的松紧或者Vision Pro的位置,这一点也无法得到更好的改善。工作人员告诉我,非Demo机型拥有更多根据个人而言的定制选项,其设计的目标是在佩戴时眼部没有漏光,所以我今天的体验并非预期该有的样子。这点仅供参考。

Vision Pro的充电线有时会绕到我的脖子的另一侧,这点其实还是有些麻烦的。在你带上Vision Pro后,你移动头部会相对没带上的时候更加困难。你的视野同样也会受到一定的阻碍(这点后续会展开来说)。整理线材等在你身上的东西时,这样的问题会更加明显。因此在佩戴初期,你需要确保线材摆放位置不会给你后续的运动带来负面影响以减少不必要的麻烦。

观感

我曾拥有过一台VR并长期使用过。相对那台设备而言,Vision Pro要清晰非常多。在大部分时候你看到的信息都是干净且锐利的。然而,同我想象中更为的“晶莹剔透的观感”不同,当你转动视线的时候,眼前显示的内容会出现一瞬的模糊,且在我反复确认后发现这是常态。这实际为我带来了非常多的干扰,以至于我感觉到了明显不适和眩晕。同时屏幕在特定视角下有明显发绿现象,需要多次手动调整佩戴位置才能解决。

在默认状态下,Vision Pro会把你眼睛看到的东西映射到屏幕里去,且延迟相对较低。我佩戴了Vision Pro后站起身走了两步,发现是可以做到正常移动的。我同时也能够看到自己的双手。只是,你会有一种“眼睛变成广角镜头”的错觉,会发现现实物体的比例和你裸眼有出入。即便Apple Store光线充足,部分相对较远的地方也会出现噪点和模糊。只能说戴上Vision Pro理论上来说你依然可以和不戴的时候一样移动做想做的事情,可这样的体验一定是劣化后的。

工作人员带我体验了相册,Apple TV和一个单独App里的一些空间相片与视频内容,值得一提的有四个。第一个是几个小孩在我面前唱生日歌吹蜡烛;第二个是Apple做的恐龙相关的体验,是一个单独的App;第三个是Apple TV一个类似混剪一样的内容,会把你带到一个演唱会现场。最后一个是Apple TV里Supermario的电影片段。

第一个视频给我的感觉就像那几个小孩在你面前一样,配合机器上质量不错的扬声器,显得非常生动。扭动头部时,视频会被锁定在你的视野中心点(想象FPS的屏幕准星)并跟着你的视线一起移动,而非静态的窗口那样停在原地不动,好比在无法离开当前座位前提下看一场舞台剧。

第二个恐龙也是很奇特的一次体验。将食指伸出,会有一只蝴蝶停在你的食指上。虽然你还是能明显看出它的肢体有“悬空”的迹象,但其距离已经足够小,且会跟着你手的运动而移动。恐龙是从一块屏幕里出现的,其建模逼真且非常立体。你可以感觉到它就在你面前,但当有现实中的人离你距离较近的时候,Vision Pro则会把显示的虚拟内容适度调整到更为透明的状态中去。这个视频当你转动头部的时候,这些内容并不会跟着你的头一起移动,而是会停留在那里。

第三个和第四个内容都是被固定住的画面。不同点在于第三个内容的画面是类似你面前一百八十度区域的立体呈现,而第四个是把一个窗口投影到远处然后“关灯”让你身处在剧院一般的环境中观影。实际看下来,这两个反而是基本没有给我留下很多印象的。一来在第三个视频里,我看到的很多地方都出现了模糊。想象你在一个巨型3D IMAX荧幕上看1080p甚至720p视频的感觉,那就是我当时的感觉。第二个则是平平无奇的一段电影切片,但要我说,我还是会偏向把屏幕拿在手里看。

最后,工作人员展示了一个非视频的场景:旋转表冠以让一个虚拟的场景融入到我的现实中。我试了几个不同的东西,一个是森林与湖泊,另一个是月球,还有一个是木星。怎么说呢,它们的确是能够做到一瞬让我视野覆盖满现实外的新景色,但由于这些景色全都是静态的,比起说“身临其境”更不如说“眼临其境”,充其量可以当个壁纸。

总之,Vision Pro在特定场景确实为我带来了身临其境的感觉,但于我而言这些只能算新鲜而并未达到震撼。3D的空间视频确实达到了身临其境的呈现,可我并不觉得在观看这种视频时我有被带入到了另一个世界。头部移动时的画面模糊,鼻子下的漏光以及压在头上依然明显的设备存在感,都不会让我在选择观看视频时考虑佩戴Vision Pro。

系统

在开始前,工作人员让我用一部iPhone的前置镜头组扫描了我的面部,类似录入FaceID一样。过程非常快。当我带上Vision Pro时,我需要在张开双手让其扫描。之后,我要盯着出现的六个小球不动然后捏合我的右手食指和拇指,重复三轮直到系统确认完毕。我这里从Apple官网找了一张核心的手势在这里。

在进入Vision OS后,我需要按下设备右上方的物理“表冠”按钮才能打开程序界面。打开的每一个程序窗口都会自动出现在你视线盯着的位置。你需要看向那些程序底部的小横条然后做出双指捏合的动作并保持不动才能把窗口拖到各种各样的位置去。苹果官网有一张宣传图如下,实际观感也是类似的,可以参考。

一般而言,每个应用的窗口都类似可以被凭空变出来的没有物理碰撞体积的屏幕-m一般。它们可以被自由的放大和缩小的,也可以被自由的摆放到空间中的任何位置。可以通过手势把它拉远和贴近。

关闭窗口则必须要把目光盯向窗口下方小横条,并等到边上出现“x”后盯着它,双指捏合才可关闭。这在我看来非常奇怪,因为你完全就可以设置成页面左上角或者右上角传动形态的三个按钮,我也不知怕苹果到底是出于什么样的考虑才这么做的。

过程中我问了工作人员是否有类似iPhone或iPad那样的任务视图,即做出某种手势或操作让所有窗口都呈现出来,并自由关闭。他告诉我现在并没有这样的功能,因为窗口位置的摆放是基于现实物理空间你手动操作的。你只能用眼睛找到他然后手动关闭。我不知道在他的iPad上,我的操作是否可以被他那边以触屏的形式关闭,但他确实能通过某些操作来唤出一些新的窗口。

我也看了Vision OS的设置。让我比较震惊的一点是这设备的亮度是不可手动调整的,我也没有找到能手动调整的选项。工作人员向我确认了这一点。同时,当你正把Vision Pro的屏幕进行镜像时,你是无法进行屏幕录制的。控制中心的呼出方法是把右手手指合拢然后手翻一个面,盯住出现时新选项再捏合。这虽然也不算特别麻烦,但也绝不算简单快捷。和手机或Mac一个点击或手势就能做到的事情比,这样的组合显得更加笨重了。

因为我无法体验和实体键盘或其它Apple设备的联动,我只能尝试使用虚拟键盘打字。这体验一言难尽。其就类似使用手柄在主机界面打字一样,你需要分三步去输入一个字符:视线盯上虚拟键盘的那个按键,等待那个按键被选中,然后保持盯着不动并捏合手指,直到确认输入。这样的虚拟键盘使用体验甚至要比手柄更加糟糕。除了用眼睛盯和捏合手指这样的输入外,你还有一种选择就是拿食指去戳面前的虚拟键盘。这两种方式体验下来,我只能总结虚拟键盘是应急的时候用的。用这种方式输入文字或者写东西的效率是非常低下的。

当然,由于这台机器没有连接我的设备上,这只是做个演示。我实际上并未输入任何东西。然而,头垂下去的时候Vision Pro的重量是不可忽视的。

我最后浏览了Vision OS的应用商店。相比其它Apple设备的平台,出现在应用商店的App真可谓少得可怜。我在浏览时眼熟的只有Microsoft Office,其它基本一个都不认识。工作人员告诉我,我在demo机器上看到的应用商店和在实际的机器上看到的是完全一致的。这也让我确定目前Vision OS的生态开发者严重不足。比起其它大大小小的问题而言,这才是我认为当今Vision Pro面临最严重的缺陷:没有应用。

结尾

整个体验下来,如开头所言。Vision Pro确实并未满足此前我对它期待。即便Vision Pro和一台手机一样贵,以它当前的状态,我依然无法说服自己以任何理由去购买它。更何况,它实际的售价搭配上镜片,已经超过了三万人民币。于我而言,这笔钱意味着更多的东西。

硬件方面,我认为Apple最需要解决的问题就是“混合现实”里的混合。即便Vision Pro正竭尽全力的用当下最先进的技术去给我们一个无缝交融在一起的世界,其实际体验依然远低于能说服我去长时间使用的质量。核心问题所在,无外乎重量和观感。在那么明亮的Apple Store都能有明显的画面劣化与失真,那在更暗的场景中,这些只会变得更加糟糕。同时,Vision Pro取下来的那一瞬间,我的确感受到了一种视野重新明亮清晰,头部回归自由活动的解脱感。这足以说明其佩戴的体验和舒适相去甚远。做到这些,Vision Pro才能在基础的体验上保证用户能持续使用的可能。

软件方面,Vision OS的很多交互逻辑虽标新立异且足够稳定,但并不能称得上易用,有些地方甚至反直觉。我无法说服自己放下手机去用它做任何手机能做的事情。其生态本身也非常需要开发者共同努力去开发与适配新的应用。抛开与MacOS联动的可能,我实在想不出它这个机器单拎出来,存在的意义除了一开始Apple给我展示的几个影音娱乐场景外还有什么。而谁又会为了这样的场景花费三万多人民币呢?

空间计算的未来,是什么?假设上述内容都可以得到解决,那未来这样的设备该是如何模样的?我虽然无法在技术上给出足够脚踏实地的方案,但我可以以消费者的角度去做出一些遐想。

在我看来,我的眼镜就是Vision Pro视觉传输应该需要达到的状态。如果未来的现实技术能让透明材质的玻璃上出现色彩,如果我的眼镜里能在把现实的光源传递到我的眼睛中的同时,出现彩色可交互的窗口,这就可以直接解决Vision Pro面临的问题,从最底层的技术实现上。同时,我个人一直主张硬件在分布式设计时如果体验更好就无需追求一体化的理念。这样的眼镜作为视觉的输出设备,而输入设备则可以交给类似指环或者手套这样的设备去实现手势的传感,背上一个斜胯带,上面有需要的摄像头去实现光学信息的捕捉。最后,把计算单元交给一个类似手机的东西去做。三个模块之间的传输使用私有协议,类似内置接收器一样。由于物理位置足够接近,所以信息和信息之间的传输可以尽可能做到低延迟。考虑到计算量和信号干扰,我会寄希望于未来出现更为高效的无线信号传输手段和更强大的移动处理器。这样实现一套系统输入运算输出三部分的分离,可以从根源避免让头部承受太多压力和Vision Pro当前不可避免的侵入式设计。各个单元的模块化也可以让维修更容易,问题更好定位。要说坏处,可能就是充电和装配会更麻烦。但既然是在想象未来,也许无线充电也已经实现了?

当然,脑机接口也许才是最根源也最具野心的解决方案,直接跳过外界环境和人脑的信息处理器官直接进行沟通,直接读取人体系统的信号输入并处理后输出给人脑可能才是终极解决方案,毕竟这世上不会有比“眼睛”更好的近距离摄像头了。

从科幻和不着边际的遐想回归现实,我所主张的都是从问题出现的根源去解决问题。从“通过摄像头传输信号到屏幕”到“自然光学信号里混合后期加入的计算图像”再到“直接与大脑进行沟通,提取自输入然后自输出循环”,这三者的技术都存在极大的鸿沟。当前的世界也许能勉强把第一点做到部分场景可用,但持续探索更多的方向和透明发光材质,探索更高效的信号传输手段才能从根源上为空间计算带来突破。如果一台Vision Pro能和我的眼镜一样轻,同时没有我今天切实体验到的视觉模糊等等因为画面来自光学采集设备的问题等,我想届时我才有选择它的理由。